أظهرت كلّ من برمجيات “WannCry” و “NotPeya” الخبيثة عام 2017، أنّ الهجمات الإلكترونية التي تستهدف البنى التحتية، والبنوك والمستشفيات وحتى الهواتف الذكية… تنطوي على إمكاناتٍ تخريبية كبيرة على مجتمع المعلومات. فقد استطاعت “WannCry” شلّ مئات أنظمة تكنولوجيا المعلومات، كما كلّفت “NotPeya” شركة “Merck” الألمانية وهي واحدة من أكبر عمالقة الأدوية في العالم، خسائر وصلت إلى 300 مليون دولار أميركي. ومن المتوقّع أن يتسبّب هذا النوع من البرمجيات أضرارًا قد تصل إلى 6 تريليون دولار في العام المنصرم.

ومع مرور الوقت، تتصاعد وتيرة الهجمات السيبرانية وتأثيرها وتطوّرها. ويرجع هذا التصعيد إلى عدة عوامل، بينها أنّ الهجوم أسهل من الدفاع، نظرًا لأن الدفاعات مليئة بالثغرات، وبالتالي ففرص نجاح الهجمات أكبر من عدم نجاحها. ويمكن للذكاء الاصطناعي أن يحسّن بشكلٍ كبير من إجراءات الأمن والدفاع السيبراني. إلّا أنّ هذه التقنية قد تكون عاملًا في زيادة الهجمات أكثر، لأنها تستطيع تحديد نقاط الضعف في الأنظمة التي غالبًا ما تفلت من خبراء الأمن الرقمي البشريين، وهذا ما أشار إليه تقرير التوقّعات الأمنية لشركة “فورتينت” الأمريكية العام الماضي. وعند النظر إلى دور الذكاء الاصطناعي في الأمن السيبراني على مستوى الأنظمة، هناك ثلاثة مجالات ذات تأثيرٍ كبير يتمّ البناء عليها: القوة ، والمرونة، واستجابة النظام. إلّا أنّ كلّ منها يقترن بمخاطر أخلاقية، إذا تُركت دون معالجة ، فقد تعيق اعتماد الذكاء الاصطناعي في مجال الأمن السيبراني أو تسبّب مشاكل كبيرة. وهذا ما سنتناوله أدناه:

1- قوة النظام

يعدّ الذكاء الاصطناعي لاختبار البرمجيات مجالًا جديدًا للبحث والتطوير. وتعرّفه جمعية الذكاء الاصطناعي لاختبار البرمجيات (AISTA) أنه “مجالٌ ناشئ يهدف لتطوير نظم الذكاء الاصطناعي بهدف اختبار البرمجيات، والمساعدة في التحقّق من صحتها، وتحرير الخبراء البشر من المهام الشاقّة، وكذلك تقديم اختبار أسرع وأكثر دقة لنظام معين”. من هنا، يمكن للخوارزميات الذكية نقل اختبار البرمجيات إلى مستوًى جديد، ما يجعل الأنظمة أكثر قوّة. ومع ذلك ، يجب أن نكون حذرين كمجتمعات في الطريقة التي يجري من خلالها استخدام الذكاء الاصطناعي في هذا السياق، لأن تفويض الاختبار لهذه التقنية يمكن أن يؤدي إلى حجبٍ كاملٍ للخبراء البشر. ونفترض أنّ هذا من شأنه أن يكون إجراء غير حكيم. وعليه، يتعيّن على خبراء الأمن السيبراني الاستمرار في اختبار الأنظمة بالقدر المطلوب، لنفس السبب الذي يجعل الأطباء مثلًا يستمرّون في قراءة فحوصات صور الأشعة السينية وفق ما أكّد لي بعضهم، وذلك في حالة عجز الذكاء الاصطناعي أو أخطأ في قراءة وتحليل البيانات الطبية.

2- مرونة النظام

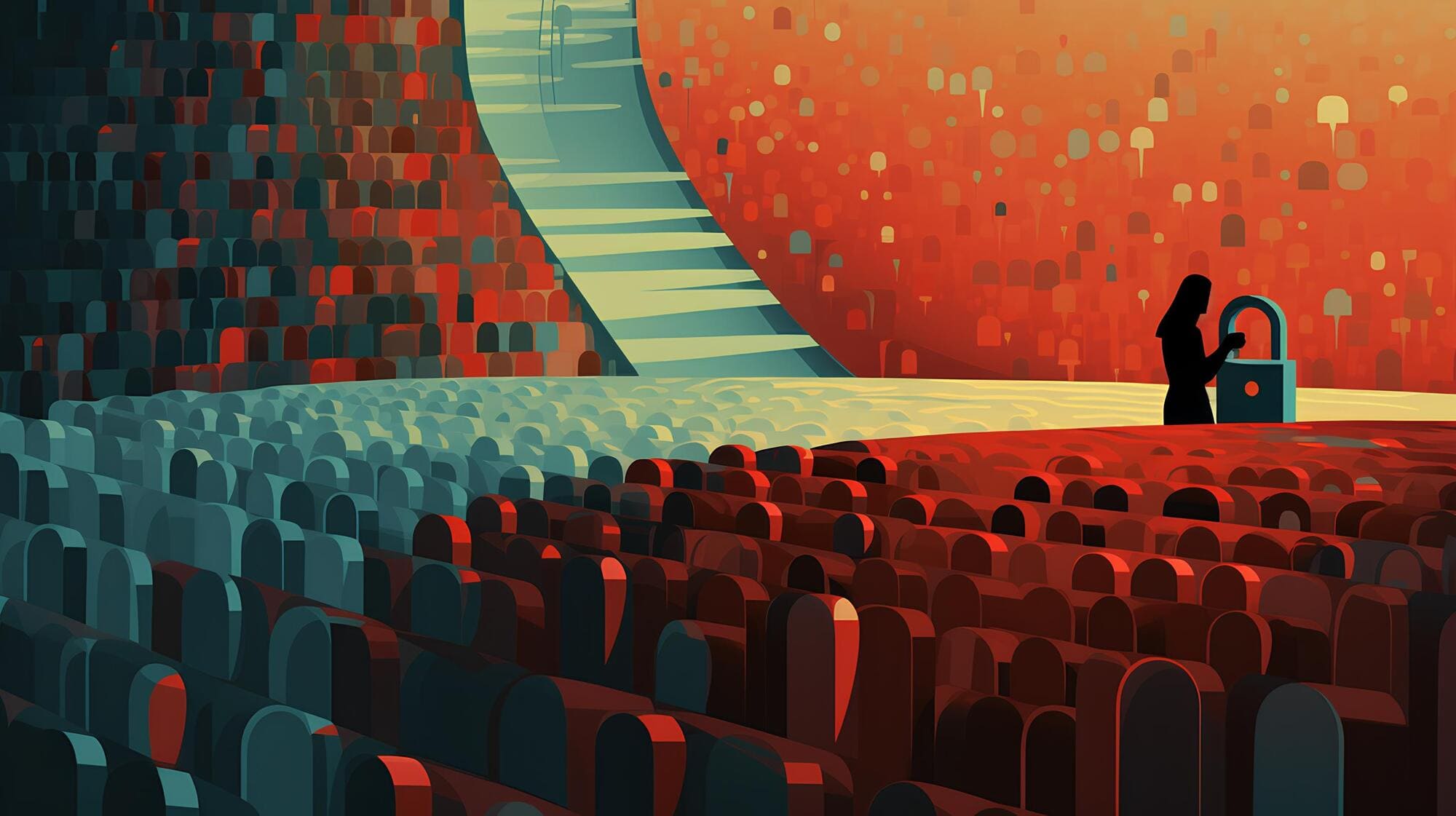

ينتشر الذكاء الاصطناعي على نحوٍ متزايدٍ للكشف عن التهديدات والشذوذ المحتملة. وتقوم الخوارزميات بتحليل البرامج الضارة والفيروسات للكشف عنها، وبعضها قادر على عزل التهديدات وأجزاء من الأنظمة للتحقّق من سلامتها. وقد تصل برمجيات الفحص إلى رسائل البريد الإلكتروني، والأجهزة المحمولة، وحتى بيانات المرور على الشبكة. وقد يمتدّ الفحص ليشمل المستخدمين أيضًا من خلال مراقبة السلوك الرقمي مثل تسجيل الطريقة الفريدة التي يحرّك بها المستخدم مؤشر الفأرة (الماوس) حوله، وإنشاء ملفات تعريف بيومترية. بمعنى آخر، تتبّع وجمع البيانات المتأتّية من التفاعل البشري مع التطبيقات أو المواقع الشبكية. الخطر واضح تمامًا هنا. صحيحٌ أنّ الذكاء الاصطناعي يمكن أن يؤدي إلى تحسين قدرة النظام على التصدي للهجمات ومواجهتها، لكنّ هذا يتطلّب رصدًا ومراقبة مكثفة للنظام وجمعًا شاملًا للبيانات. وبالتالي، يضع خصوصية المستخدمين على المحكّ، ويعرضّهم لمخاطر إضافية في حال انتهاك سرية البيانات أو تسريبها.

3- استجابة النظام

من ناحية، سيزيد الذكاء الاصطناعي من قدرة المهاجمين، ويوفّر وسائل جديدة أكثر تعقيدًا لتنفيذ الهجمات السيبرانية. لكن من ناحيةٍ أخرى، سيعمل على تحسين الاستجابة والتدابير المضادة. وتتوفّر بالفعل أنظمة الأمن السيبراني “المستقلة” و “شبه المستقلة” التي تعمل على استجاباتٍ محددة مسبقًا للهجوم. كما يجري أيضًا تسويق أنظمة قادرة على محاكاة السلوك العدائي للبرمجيات الخبيثة. إلا أننا بتنا نشهد تصميم سلالات من البرمجيات الضارة مدعومة بالذكاء الاصطناعي، كما هو الحال مع شركة “IBM” التي تمكّنت في وقتٍ سابقٍ من تصميم برمجية خبيثة تُدعى “Deep Locker” وهي شبكة عصبية تعمل على تحديد أهدافها وقادرة على التخفّي حتى الوصول إلى وجهتها. وقد يكون لهذه القدرات دور في تعزيز استراتيجيات الأمن السيبراني وتطويرها، بيد أنّ تطبيقات الذكاء الاصطناعي لاستجابة النظام تشكّل بعضًا من أكثر التحديات إلحاحًا، الأمر الذي حدا بأعضاء مجلس الشيوخ الأميركي عام 2018، لتقديم اقتراحٍ يقضي بالسماح للشركات اختراق المهاجمين كردّ على الهجمات الإلكترونية التي تستهدفها. وعليه، فهذه التقنية يمكن لها أن تشكّل أرضيةً خصبة لهجماتٍ أكثر تخريبًا قد تستهدف الأنظمة، ما يؤدي إلى عواقب خطيرة.

هناك إذًا حاجة إلى إجراء مراجعات أخلاقية حيال أنظمة الذكاء الاصطناعي في مجال الأمن السيبراني لتجنّب المراقبة الجماعية، والمخاطر الناتجة عنها. ويعدّ التصميم الأخلاقي ونشره أول خطوة ضرورية في هذا الاتجاه، لا سيما عند النظر في استخدام الدول لهذه التقنية لأغراض الأمن السيبراني. ويتعيّن التفكير في الكثير من المسائل خصوصًا على مستوى حماية البيانات من الانتهاكات، فضلًا عن تنسيق الجهود بين الجهات المعنية لجعل الذكاء الاصطناعي قوةً للخير في خدمة المجتمع الإنساني.