يواجه الذكاء الاصطناعي العديد من التحديات، إذ لا يحتاج إلى كمياتٍ هائلة من البيانات لتحقيق نتائج دقيقة فحسب، بل لأن يكون أيضًا قادرًا على ضمان عدم تحيز البيانات، بالإضافة إلى ضرورة الامتثال لقوانين خصوصية البيانات على نحوٍ متزايد. وقد شهدنا عدّة حلولٍ مقترحة على مدى الأعوام القليلة الماضية لمواجهة هذا النوع من التحديات، بما فيها الأدوات المصممة لتحديد التحيّز والحدّ منه مثل What If التي أطلقتها “جوجل” عام 2018 والتي تسهّل حتى على غير المبرمجين اختبار نماذج التعلّم الآلي واستكشافها وتصحيحها، أو AI Fairness 360 من “آي بي إم” وغيرها. وهناك أيضًا الأدوات التي تحجب هوية بيانات المستخدمين مثل CloverDX، والبرامج التي تضمن عدم جمع البيانات إلا بموافقة المستخدمين. إلّا أنّ كُلّا من هذه الحلول يواجه التحديات الخاصة به. وفي الوقت الراهن بتنا نشهد صناعةً جديدة من المتوقع أن يكون لها حضورًا أقوى مع الوقت: البيانات المصطنعة (Synthetic Data) والتي سنتحدث عنها في هذه المقالة.

1- بيانات تحاكي الواقع لكن ليست حقيقية

إنّ جمع بيانات العالم الحقيقي يعدّ مكلفًا للغاية ويستغرق وقتًا طويلًا، ولا تستطيع كل الشركات تحمّل التكاليف. ونتيجةً لذلك، بات يتمّ اللجوء إلى استخدام البيانات المصطنعة، وهي عبارة عن بيانات يتمّ توليدها اصطناعيًا وذلك من خلال الاعتماد على الخوارزميات الحاسوبية بدلًا من جمعها من العالم الحقيقي. ويجب أن تحوي مجموعة البيانات المصطنعة نفس الخصائص الرياضية والإحصائية مثل مجموعة البيانات في العالم الحقيقي التي تحلّ محلها. بمعنى آخر، هي بمثابة مرآة رقمية للبيانات الحقيقية، والتي تتيح تدريب أنظمة الذكاء الاصطناعي. ونظرًا لكون هذه البيانات تحاكي الخصائص الإحصائية للبيانات الحقيقية، يمكن استخدامها في العديد من المجالات مثل اختبار المنتجات والخدمات الجديدة أو تدريب نماذج التعلم الآلي والتعلم العميق أو قياس الأداء. وهناك بالفعل اتجاه نحو إيجاد الحلول المبنية على البيانات المصطنعة من قبل الشركات الناشئة التي تزيد يومًا بعد يوم.

2- إشكاليّات البيانات الحقيقية

على مدى السنوات القليلة الماضية، كان هناك قلق متزايد بشأن الكيفية التي يمكن بها للتحيّزات المتأصّلة في مجموعات البيانات أن تؤدّي عن غير قصد إلى استمرار التمييز المنهجي في خوارزميات الذكاء الاصطناعي. وتتوقّع شركة “جارتنر” للأبحاث خلال عام 2022، أنّ ما يقرب من 85% من مشاريع الذكاء الاصطناعي ستقع في نتائج خاطئة وذلك بفعل التحيّز في البيانات. ومن جهةٍ أخرى، أدّى انتشار خوارزميات الذكاء الاصطناعي أيضًا إلى تزايد المخاوف بشأن خصوصية البيانات. وهذا بدوره دفع لاستصدار قوانين أكثر حزمًا بما يتعلّق بخصوصية وحماية بيانات المستهلكين كما هو الحال في دول الاتحاد الأوروبي مع قانون تنظيم حماية المعلومات العامة المعروف اختصارا بـ”جي دي بي آر” (GDPR)، وولاياتٍ أميركية كولايتي كاليفورنيا و فرجينيا، وذلك بغية منح المستهلكين مزيدًا من السيطرة على كيفية جمع الشركات للبيانات الشخصية الخاصة بهم وإدارتها، حيث تمنح مثل هذه القوانين المستهلكين مزيدًا من التحكّم في بياناتهم الشخصية، من خلال الحقّ في الوصول إليها أو استحصال نسخةٍ منها، وتصحيحها، وحذفها. وكذلك في اختيار عدم بيع بياناتهم الشخصية، ورفض الوصول إلى البيانات عن طريق الخوارزميات لأغراض الإعلان أو تنميط المستخدمين. ومع تقييد الوصول إلى هذه البيانات، صحيح أنّ المستخدمين قد يكتسبون قدرًا معينًا من الحماية الفردية، إلّا أن ذلك يتمّ على حساب فعالية الخوارزمية. وعليه، فبدون الوصول إلى بياناتٍ وافرة قد يؤدي لمحدودية الاستفادة من الذكاء الاصطناعي مثل المساعدة في التشخيصات الطبية والأبحاث المتعلقة بالعقاقير وغيرها.

وقد يتمثّل أحد البدائل المطروحة والذي كثيرًا ما يُستخدَم في عدم الكشف عن الهوية. فالبيانات الشخصية على سبيل المثال، يمكن أن تكون مجهولة الهوية عن طريق إخفاء أو إلغاء خصائص معينة، مثل إزالة الأسماء وأرقام بطاقات الائتمان من معاملات التجارة الإلكترونية أو إزالة محتوى تحديد الهوية من سجلّات الرعاية الصحية. إلّا أنّ المشكلة هنا تكمن في أنّ البيانات المجهولة العائدة لمصدرٍ واحد، قد يكون بالإمكان ربطها بمجموعات بيانات المستهلك التي قد تتعرّض مثلًا لأعمال قرصنة أو خروقاتٍ أمنية، ومن خلال الجمع بين هذه البيانات من مصادر متعددة، من الممكن تكوين صورة واضحة لهويات المستخدمين بشكلٍ عميق. وفي بعض الحالات قد يصل الأمر إلى إمكانية القيام بذلك عن طريق ربط البيانات من مصادر عامة، دون الحاجة إلى أيّ اختراق أو حتّى أعمال قرصنة.

3- حلّ البيانات المصطنعة

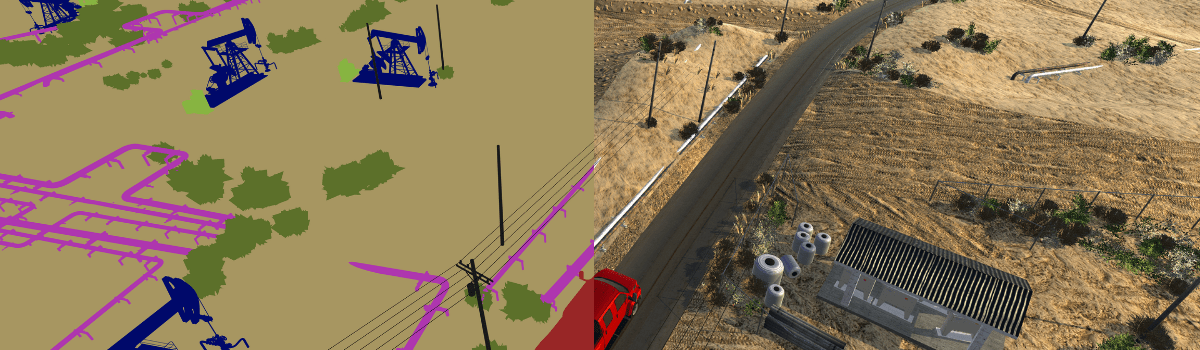

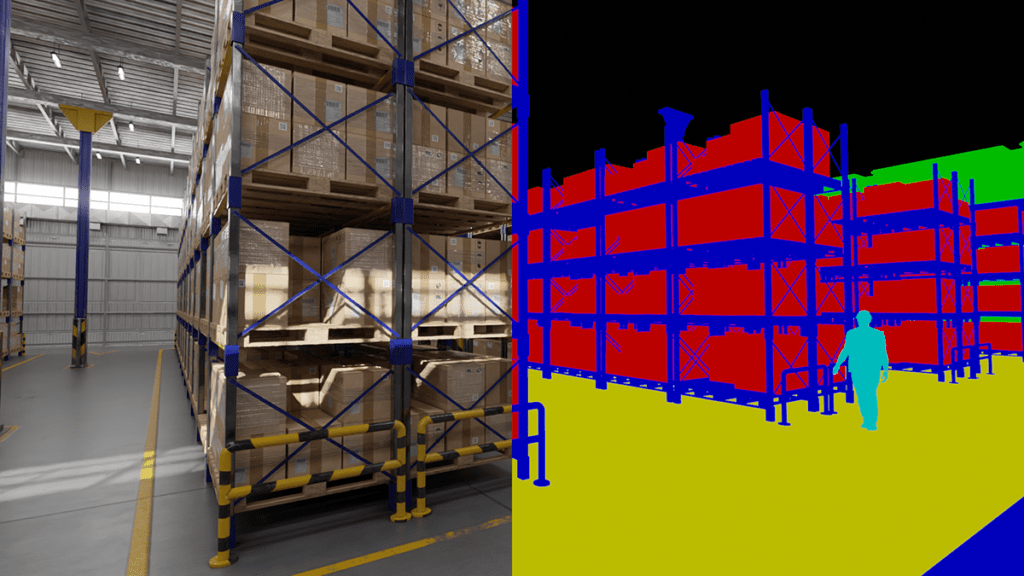

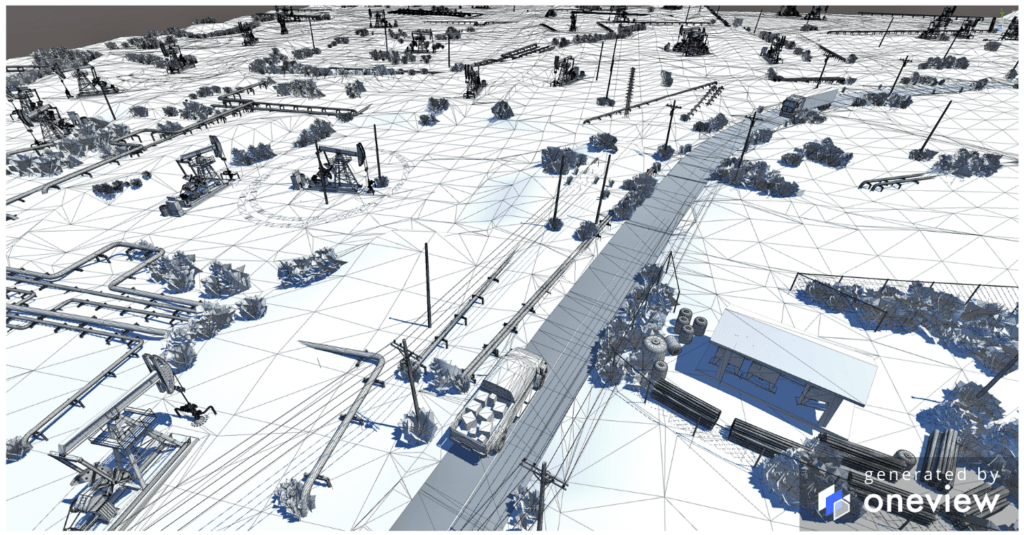

تَعِد البيانات المصطنعة بتحقيق مزايا الذكاء الاصطناعي دون الجوانب السلبية. ولا يقتصر الأمر على إخراج البيانات الشخصية الحقيقية من المعادلة فحسب، بل يتلخّص الهدف العام منها في أداء أفضل من بيانات العالم الحقيقي من خلال تصحيح التحيز الذي غالبًا ما ينشأ في العالم الحقيقي. وعلى الرغم من أنها قد تكون ذات كفاءة في التطبيقات التي تستخدم البيانات الشخصية، إلا أنّ البيانات المصطنعة لها حالات استخدام أخرى أيضًا. ومن الأمثلة على ذلك هو محاكاة الرؤية الحاسوبية المعقدة حيث تتفاعل العديد من العوامل في الوقت الحقيقي. كما يمكن من خلالها تغذية نماذج التعلّم الآلي بالبيانات اللازمة لعمليات التدريب، مثل السيارات ذاتية القيادة حيث يصعب الحصول على بياناتٍ حقيقية تحاكي ظروف الطريق مثلًا، أو مواقف خطيرة وما إلى ذلك. كما قد تلجأ شركات إلى الاستعانة بالبيانات المصطنعة لتجربة الأنظمة الروبوتية في عمليات المحاكاة، وذلك لأنّ هذا النوع من الاختبارات يعدّ مكلفًا للغاية ما يسمح بتحسين أداء الروبوتات دون دفع تكاليف كبيرة.

ومستقبلًا من المتوقّع أن تشهد البيانات المصطنعة نموًا مطّردًا في الاستخدام، وهذا ما يؤكّده بحث شركة “Forrester” في نُشر في العام الحالي، حيث حدّد العديد من التقنيات المهمة بما فيها البيانات المصطنعة ضمن مستوى ما اعتبرته الشركة مرحلة “AI 2.0” وهو “التقدّم الذي يوسّع إمكانيات الذكاء الاصطناعي بشكلٍ جذري”. وفي ظلّ الحاجة للتعامل مع ضرورة اختبار امتثال أنظمة الذكاء الاصطناعي للقوانين والقواعد، فقد يغدو من الضروري استخدام هذا النوع من البيانات، والذي قد يكون النهج الملائم الذي يمنح المرونة لعلماء البيانات والشركات في إنشاء بيانات الاختبار عند الطلب، مع الأخذ بعين الاعتبار الجوانب ذات الصلة بحماية البيانات والخصوصية.