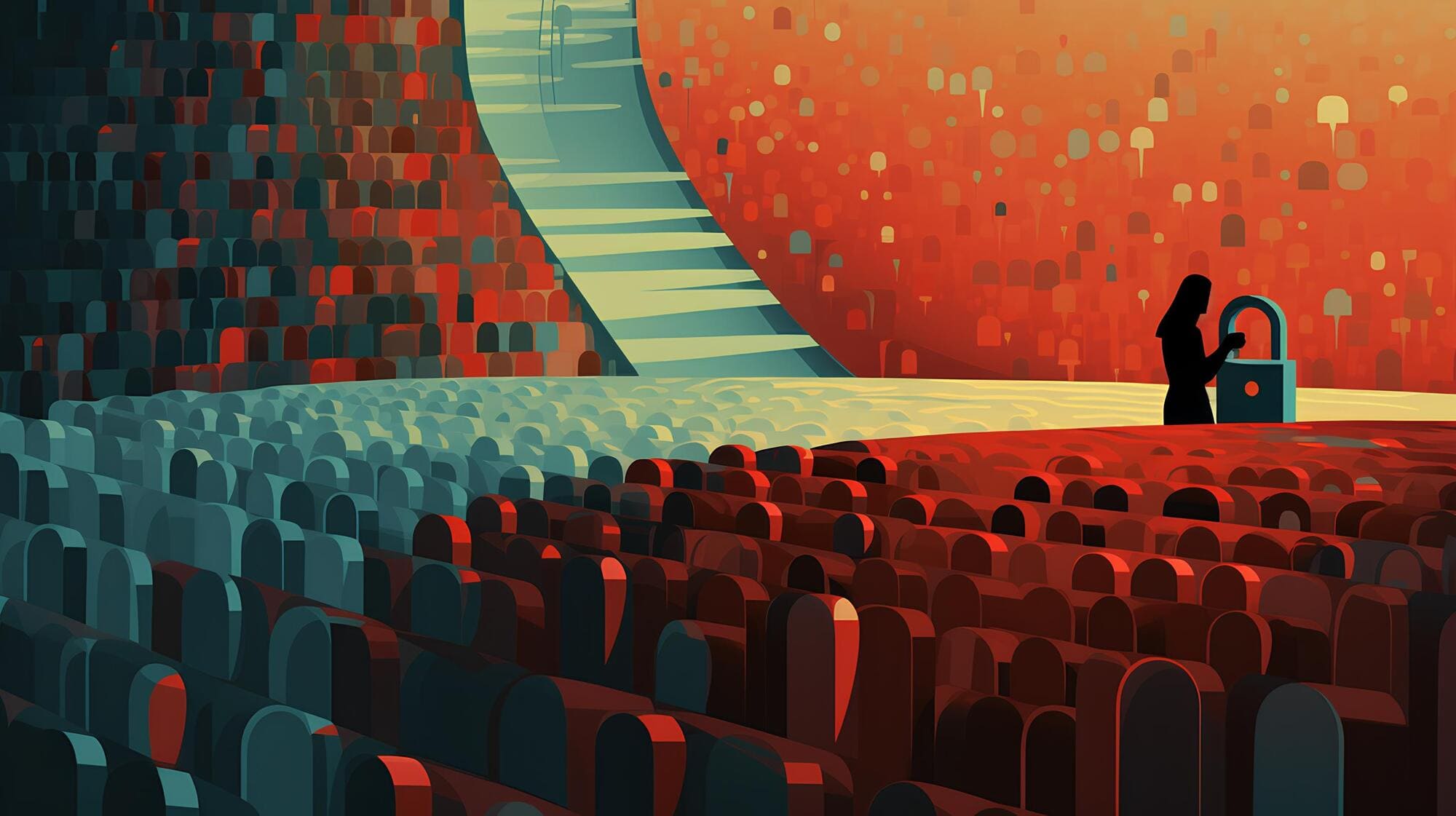

لقد سبق أن عبّر الفنانون والكتاب عن مواقفهم غير المشجعة بشأن أنظمة الذكاء الاصطناعي التوليدي، وهذا أمرٌ مفهوم. فنماذج التعلّم الآلي هذه، قادرة على إنتاج الصور والنصوص لأنه تم تدريبها على الكثير من الأعمال الإبداعية لأشخاصٍ حقيقيين، ومعظمها يُعدّ محمياً بحقوق الطبع والنشر. وفي هذا السياق، يواجه مطورو الذكاء الاصطناعي مثل شركات “أوبن إيه آي” و”ميتا” وغيرها، دعاوى قضائية متعددة في هذا الشأن.

۱. من أين تأتي بيانات التدريب؟

كما قد تلجأ الشركات الكبرى في مجال الذكاء الاصطناعي التوليدي للبحث عن مصادر غير مستغلة لمواد عالية الجودة لتدريب النماذج اللغوية الخاصة بها. وعلى سبيل المثال، ذكرت صحيفة “نيويورك تايمز” الأميركية أنّ ميتا ناقشت شراء دار نشر كاملة، وحصلت فعلياً على عددٍ كبير من النصوص للتدريب على مواد الماجستير في القانون مستقبلاً. وهناك نهجٌ آخر يتم النظر فيه، وهو الدفع للناس مباشرة لتدريب أنظمة الذكاء الاصطناعي المولدة، إما عن طريق التفاعل مع روبوتات الدردشة لتحسين جودتها أو ببساطة كتابة مواد جديدة لها.

۲. الخصوصية المهددة

في العام الماضي، قامت “زووم” بتحديث سياسات الاستخدام بطريقةٍ يبدو أنها تمنح الشركة الحق في تدريب أنظمة الذكاء الاصطناعي على المواد التي يولّدها المستخدم. وبعد ظهور انتقادات حيال ذلك، أوضحت زووم أنها “لن تستخدم بيانات الصوت أو الفيديو أو الدردشة لتدريب نماذج الذكاء الاصطناعي الخاصة بها دون إذن العملاء”. وقد بدأنا نرى هذا النهج من الشركات الأخرى أيضاً. ففي يوليو 2023، قامت جوجل بتحديث سياسة الخصوصية الخاصة بها للسماح باستخدام بيانات المستخدم للمساعدة في تدريب أدوات الذكاء الاصطناعي مثل “بارد”. كما أنها قامت بتوقيع شراكات مع جهات أخرى مثل Reddit لإضافة مواد جديدة تم إنشاؤها بواسطة المستخدمين إلى مجموعات التدريب الخاصة بها. كما أن جوجل كانت تقوم بنسخ مقاطع فيديو على يوتيوب حتى تتمكن من استخدام النصوص لأغراض التدريب. وهي ليست الشركة الوحيدة التي تسلك هذا المسار٫ فقد أنشأت “أوبن إيه آي” أداة للتعرف على الكلام تسمى “Whisper” تتيح لها أيضاً نسخ الصوت من مقاطع فيديوهات يوتيوب.

أمّا بالنسبة للشركات الأخرى التي يرتكز عملها على إدارة المحتوى الذي ينشئه المستخدمون، فالأمر لا يختلف كثيراً. فعلى سبيل المثال، تخطط شركة “أوتوماتيك” لبيع المحتوى العام المستضاف على “وورد برس” و”تمبلر” (Tumblr) لشركات الذكاء الاصطناعي. كما تدرس شركة الفيديو “Vimeo” القيام بنفس الغرض، وهي تُجري حالياً استطلاعاً حول آراء مستخدميها لمثل هذه الخطوة.

۳. تجنّب استخدام البيانات الشخصية

هناك بالفعل كتابات حول كيفية منع استخدام منشوراتنا عبر الإنترنت، لتدريب الذكاء الاصطناعي، ولكن قد يكون الأوان قد فات. فقد قامت العديد من الشركات بالفعل بتجريف الويب، واستخراج كمياتٍ كبيرة من بياناتنا وتخزينها في ملفاتٍ بصيغٍ مختلفة (SQL, Excel, CSV…) لذا فإن أي شيء نشرناه ربما بات موجوداً بالفعل في خوادم تلك الشركات. وبالنظر إلى مقدار المحتوى الذي ينشئه المستخدم، قد تبدأ الشركات في مطالبة المستخدمين بالموافقة على استخدام ملفات الكلمات والصور ومقاطع الفيديو والصوتيات الخاصة بهم والتي يتم ترخيصها لشركات الذكاء الاصطناعي التوليدي لأغراض التدريب وذلك كشرط من شروط الاستخدام. وسيكون هذا بمثابة نكسة كبيرة لخصوصية مليارات الأشخاص على شبكة الإنترنت.

وقد بدأت المعركة بالفعل، ففي الاتحاد الأوروبي مثلاً، طلبت منظمة “None of your business” واختصارها “NOYB” من هيئة حماية البيانات النمساوية (DSB) التحقيق في معالجة بيانات شركة “أوبن إيه آي” والتدابير التي تم اتخاذها لضمان كيفية التعامل مع البيانات الشخصية في مجموعات التدريب الخاصة بها لنماذج اللغات الكبيرة. وتهدف هذه الخطوة لضمان معالجة الشركة للبيانات بما يتوافق مع “قانون تنظيم حماية المعلومات العامة” (GDPR)، وفرض غرامة على الشركة لضمان الامتثال للقانون في المستقبل. وإذا نجحت مثل هذه الشكاوى، فمن المرجح أن تؤثر على معظم شركات الذكاء الاصطناعي التي تعمل على نماذج لغوية كبيرة في الاتحاد الأوروبي.